芝能智芯出品

芝能智芯出品在2025年10月于美国圣何塞举行的OCP全球峰会上,机架与电源成为数据中心技术演进的核心议题之一。

随着AI算力需求爆发式增长,单机架功率正从过去的几十千瓦迅速迈向100kW、甚至250kW以上,传统的交流供电和分布式电源架构已经逐渐逼近物理与效率极限。

这次大会给出的清晰方向是:从50V直流到±400V/800V高压直流(HVDC),从机架内供电到基础设施级供电,电源系统正经历一场深层次重构。

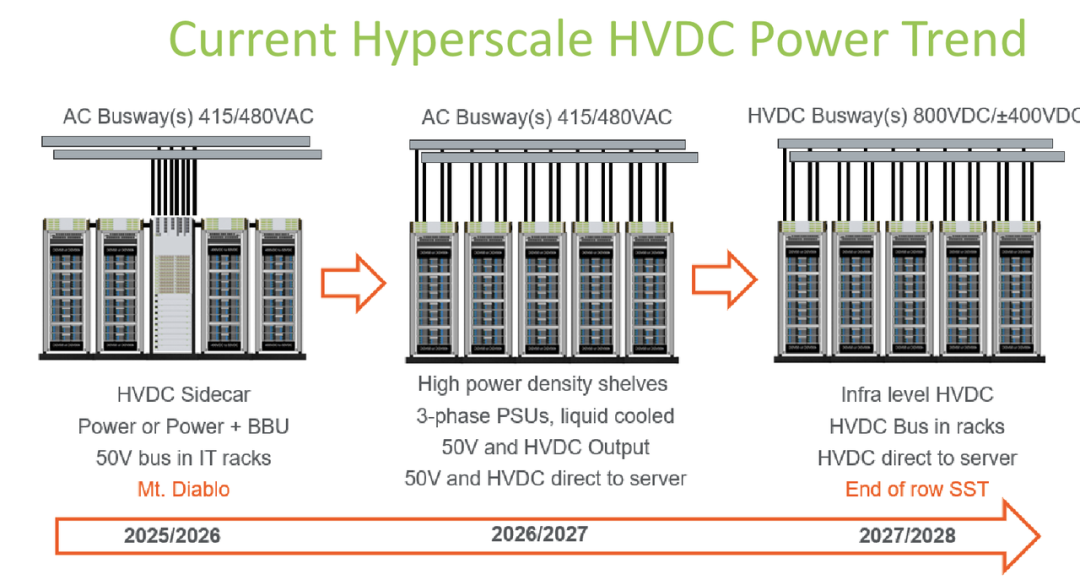

◎ 短期内(2025-2026年),主流方案仍是采用415/480VAC交流母线,配合50V直流输出的侧置电源或电源+电池备份(BBU)机架;

◎ 中期(2026-2027年),高功率密度机架将引入三相PSU和液冷设计,同时支持50V与HVDC直供服务器;

◎ 长期(2027-2028年),则会进入基础设施级HVDC阶段,机架内直接部署高压直流母线,通过固态变压器(SST)在行尾完成变换,大幅降低能量转换损耗。

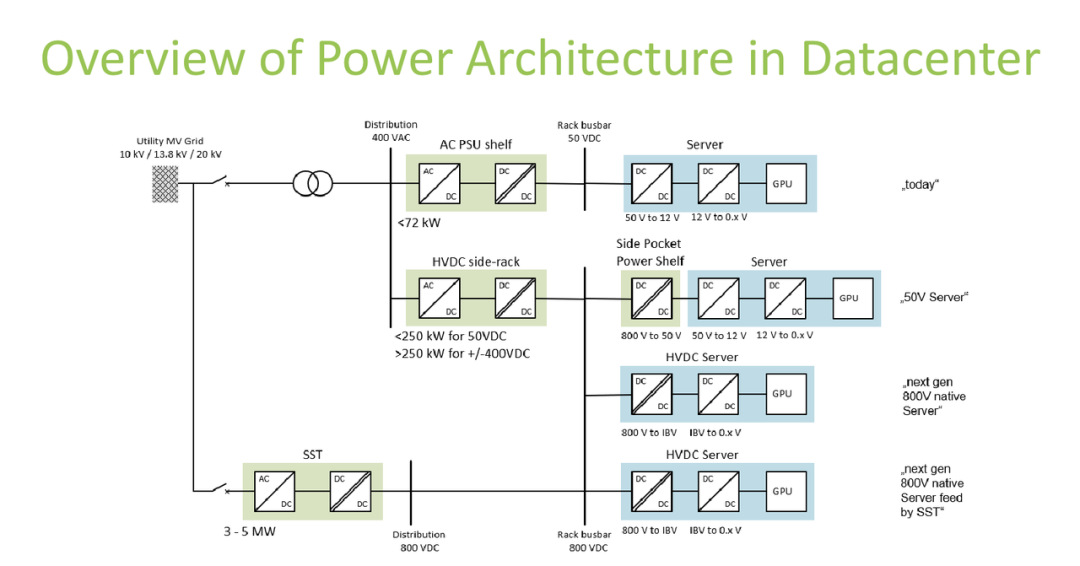

从供电架构来看,当前主流GPU服务器(单机架功率<72kW)仍采用“高压交流进、50V直流出”的路径:10kV/13.8kV/20kV电网→400VAC→AC PSU→50VDC→12V→0.xV供给GPU/CPU。

◎ 面向中期的AI机架(<250kW),开始引入HVDC侧置电源架构,由800V直流降压至50V,再逐级变换;

◎ 而面向下一代超高功率GPU(>250kW),目标是直接采用±400V或800V原生直流输入,通过中间母线电压(IBV)直接降至核心电压,支持3–5MW级配电能力。

这种演进的核心目的,是减少多级AC/DC、DC/DC转换带来的效率损失、体积压力和散热挑战。

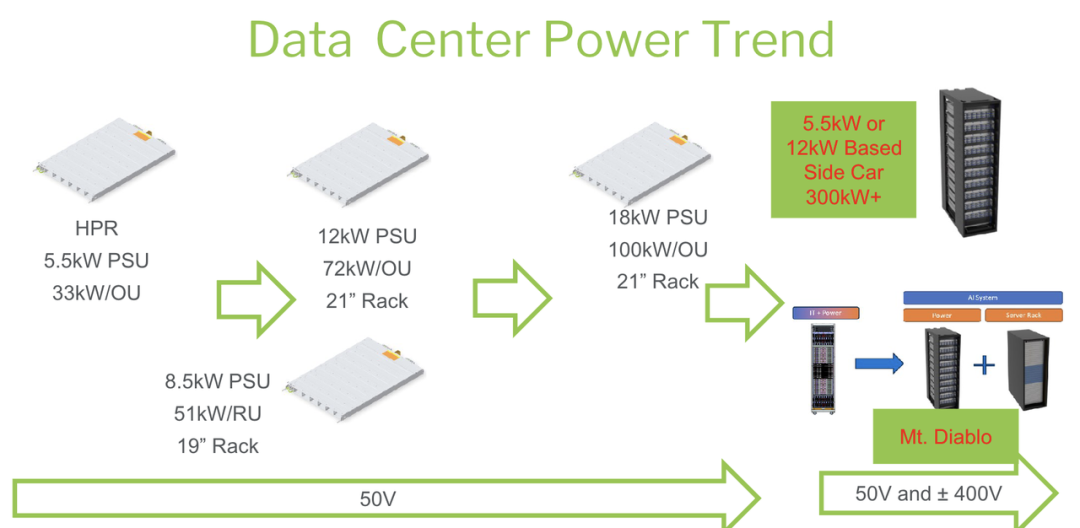

OCP高功率机架(HPR)系列给出了明确的工程参数示例。

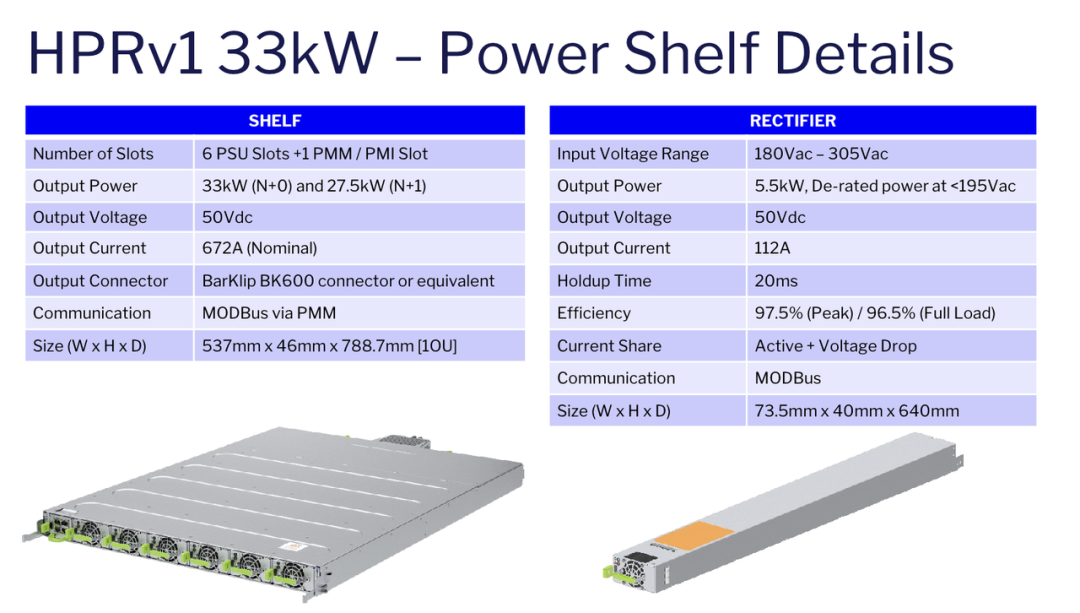

◎ HPRv1为33kW规格,1OU高度,6个PSU插槽,输出50V、672A,采用BarKlip BK600连接器;

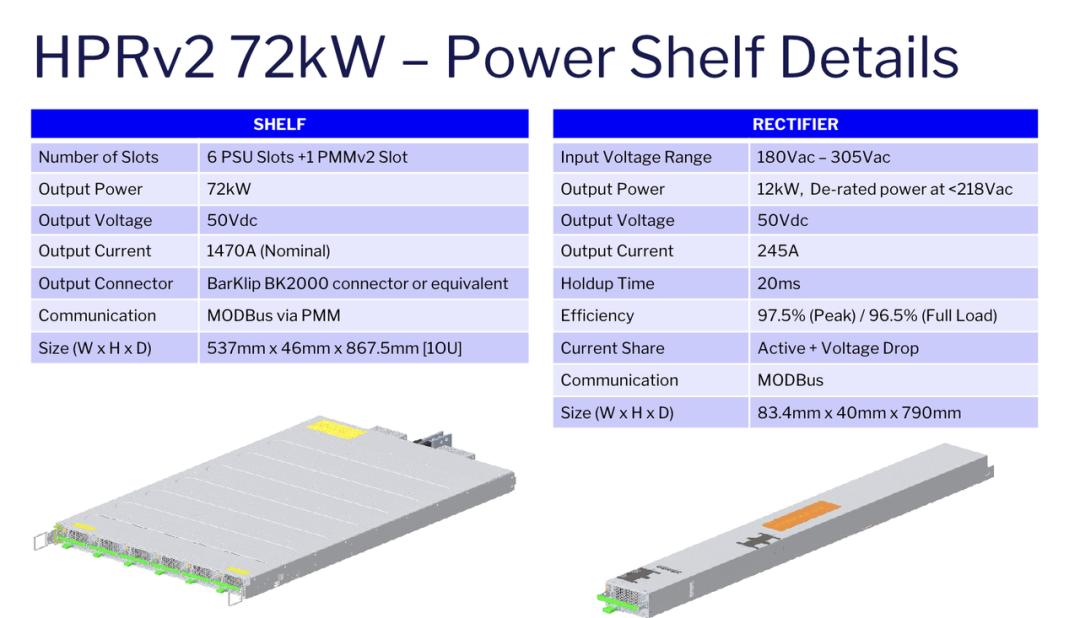

◎ HPRv2升级到72kW,输出电流1470A,使用更高规格的BK2000连接器;

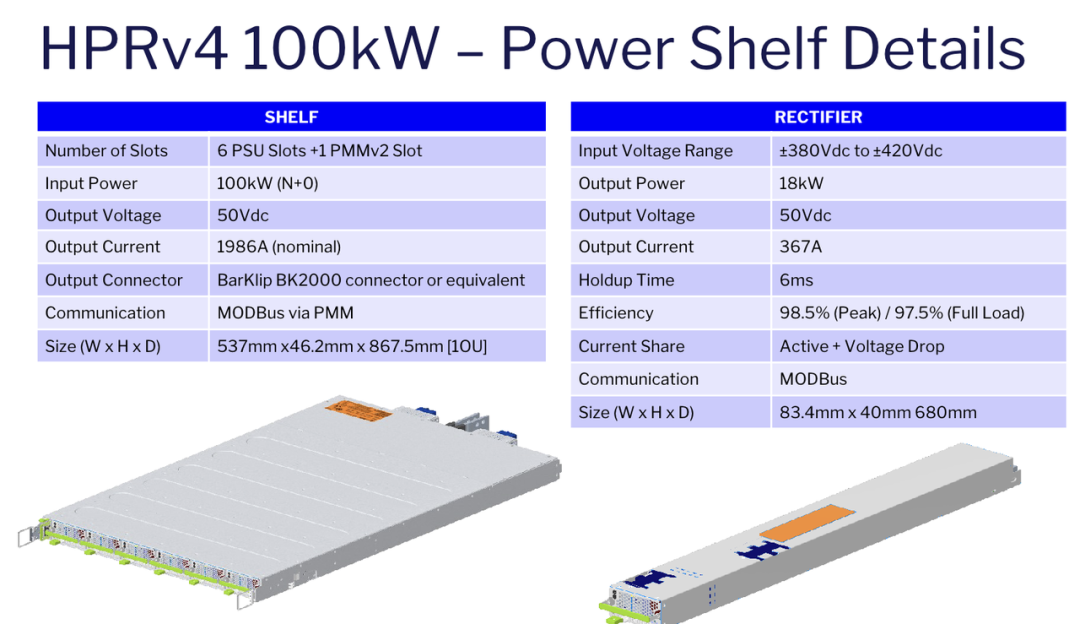

◎ HPRv4则进一步提升到100kW,输入侧已直接采用±380V~±420V直流,单模块18kW输出,峰值效率可达98.5%。

这些电源模块普遍支持MODBus通信、主动均流、20ms左右的保持时间(HPRv4为6ms),并在满载状态下保持约96.5%–97.5%的高效率。

效率测试曲线显示,在277VAC输入条件下,5.5kW、12kW模块的峰值效率均接近97.5%,即使满负载也能维持在96.5%以上,这对于高密度AI机架的能耗控制至关重要。

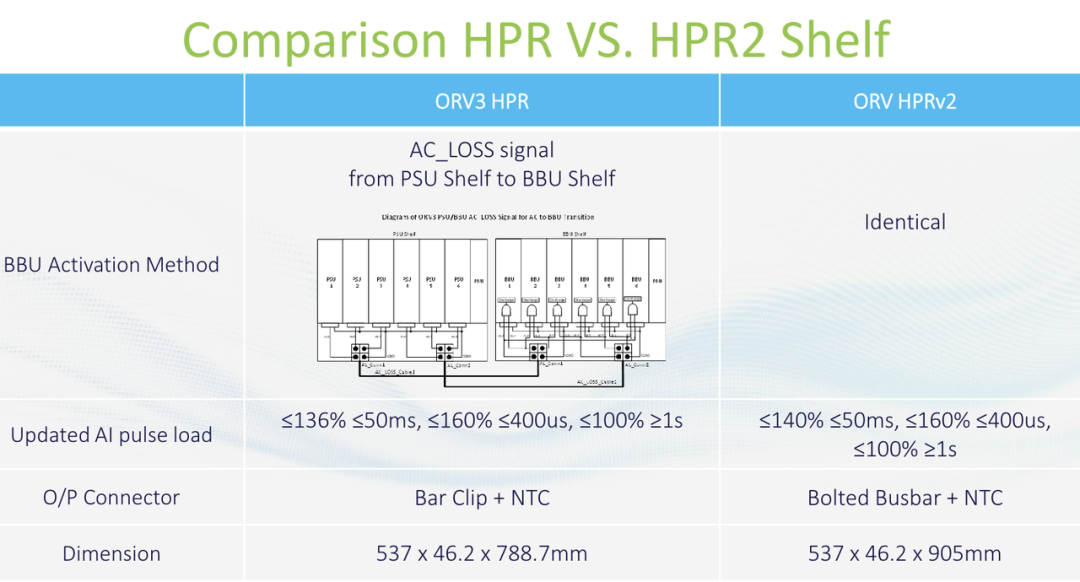

为了应对AI服务器的“脉冲负载”特性(电流在微秒级发生剧烈变化),HPRv2和HPRv4在设计中强化了瞬态响应能力。

测试显示,单模块电流上升速率可达5A/µs,整机架30A/µs,但这也带来了电压过冲和下冲的风险,其根本原因在于输出母线与BarKlip连接器形成的总电感。

未来的优化方向集中在降低母线电感、改进连接器结构以及引入更快的控制回路。

针对GPU负载的四阶段特性(EDPC+EDPP、EDPC、Idle+EDPC、EDPC),OCP还引入了电容组单元(CBU),通过储能和放电来削峰填谷,将AC侧电流波动从73%压缩到6%,显著提升系统稳定性与电网友好性。

在系统层面,HVDC侧置电源机架成为过渡阶段的重要方案。

由于AI服务器已经占据机架约3/4的空间,传统方式很难再增加电源设备,因此侧置机架通过独立布置AC-PDU、DC-PDU、电源机架、BBU和CBU,将180kW级电源集中在机架侧边,并通过800V直流母线与IT机架互联。安装过程中采用颜色编码接口,避免误插,提高部署效率。

这种方案为未来向原生HVDC供电平滑过渡提供了现实路径。

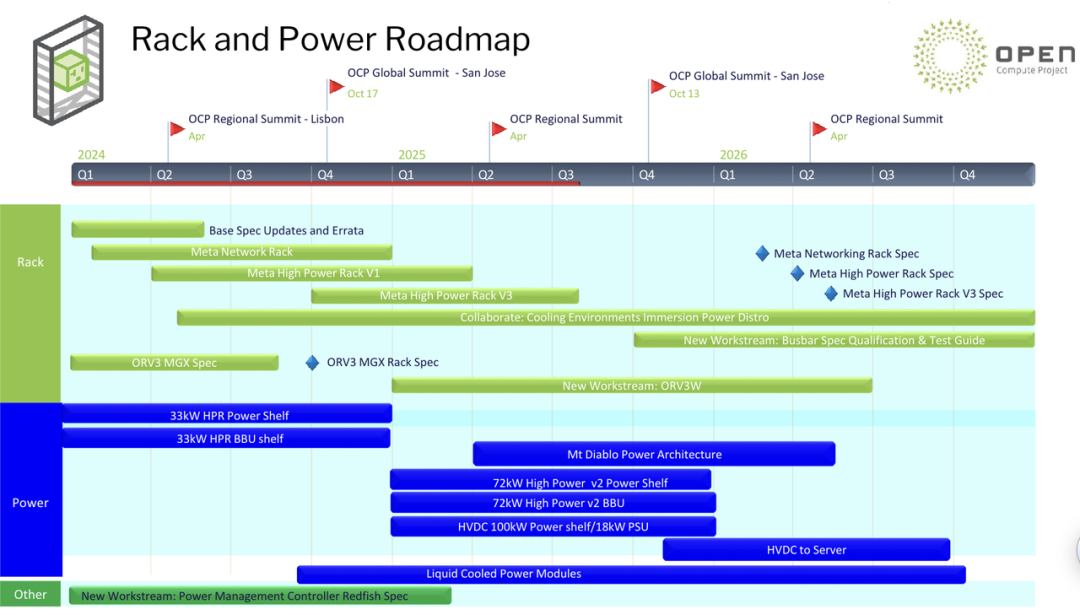

在标准与生态方面,OCP持续更新ORv3、MGX、Mt. Diablo、HVDC 100kW机架等规范,同时推动更高功率连接器、48V至GPU/CPU直供方案、沉浸式冷却与高功率Redfish电源管理架构的协同发展。

路线图显示,从2024Q4到2026Q4,行业将逐步完成33kW、72kW、100kW HPR机架的规范化,并推进±400V/800V直流供电、液冷电源模块和HVDC直供服务器的标准落地。

Advanced Energy和Delta等厂商已经实现33kW、18kW等产品量产,72kW、100kW及400V/800V级电源仍处于原型或EVT阶段,但明确指向2026年前后的规模化应用。

OCP全球峰会传递出的信息比较清楚,AI算力的爆发正在倒逼数据中心电源体系从“交流+多级转换”走向“高压直流+少级转换”,从“机架内供电”走向“基础设施级直供”,是效率和功率密度的升级,一整套架构、标准、连接器、冷却和电源管理方式的系统性重构。